Cách dùng Chatbot AI offline không cần kết nối mạng trên Opera

Nhiều trình duyệt web đang tích hợp các tính năng AI vào trình duyệt của họ thì Opera vừa trở thành trình duyệt đầu tiên tích hợp Local AI Models. Opera đang bổ sung hỗ trợ thử nghiệm cho hơn 150 biến thể Local Large Language Modelbộ (LLM) từ khoảng 50 dòng mô hình khác nhau vào trình duyệt Opera One của họ.

Vì các mô hình ngôn ngữ sẽ mang tính cục bộ nên người dùng sẽ không phải lo lắng về việc dữ liệu của họ được gửi đến máy chủ của LLM. Đó là cách sử dụng AI riêng tư và an toàn.

Để sử dụng local LLM models, bạn sẽ cần 2-10 GB dung lượng trên máy tính, tùy thuộc vào biến thể bạn sẽ sử dụng. Một số LLM được hỗ trợ bao gồm Llama từ Meta, Phi-2 từ Microsoft, Gemma từ Google, Vicuna, Mixtral từ Mistral AI, v.v. Bạn có thể sử dụng các mô hình ngôn ngữ này thay vì Aria AI từ Opera và chuyển về Aria AI bất cứ khi nào bạn muốn.

Tính năng này hiện chỉ khả dụng trong dòng nhà phát triển của Opera One. Đây là cách bạn có thể kích hoạt và sử dụng các Local AI Model trong Opera One Developer.

Lưu ý: Việc sử dụng AI cục bộ thay vì sử dụng máy chủ có thể chậm hơn vì khả năng của nó sẽ phụ thuộc vào phần cứng máy và khả năng tính toán của nó.

Tải xuống Nhà phát triển Opera One

Nếu bạn đã có Opera One Developer, chỉ cần bỏ qua phần này và chuyển thẳng sang sử dụng các mô hình LLM cục bộ.

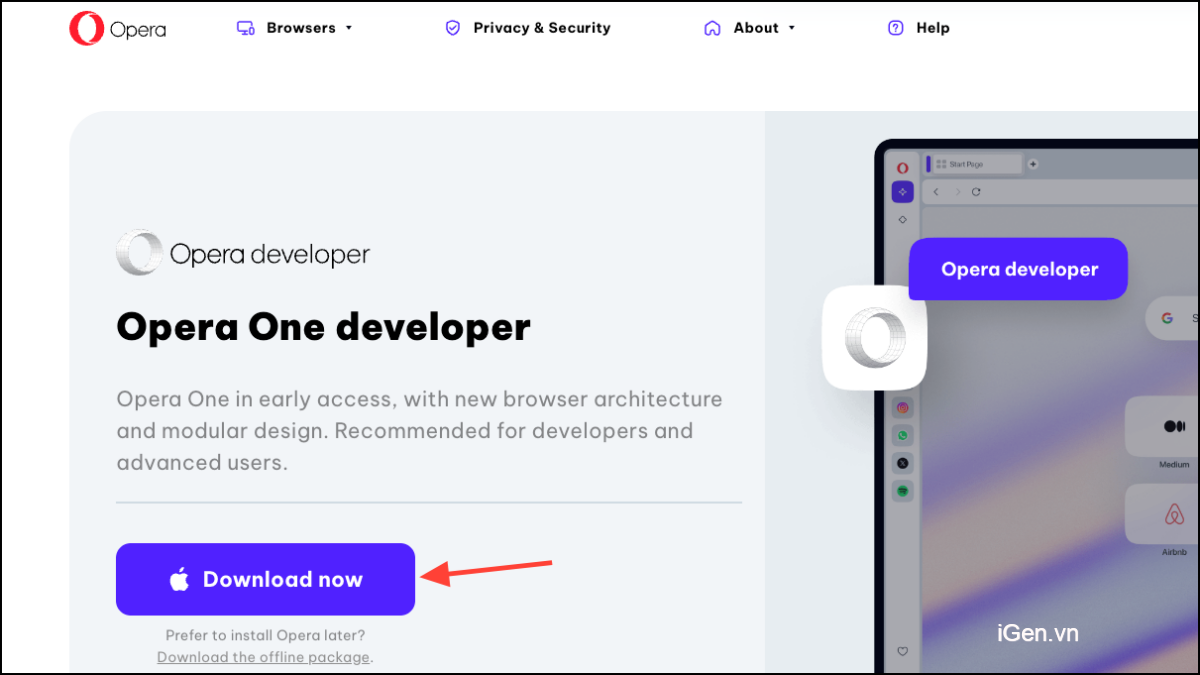

Vào link này https://www.opera.com/browsers/opera/beta để tải Opera One Developer . Cuộn xuống và nhấp vào ‘Tải xuống ngay’ trên ô Opera One Developer.

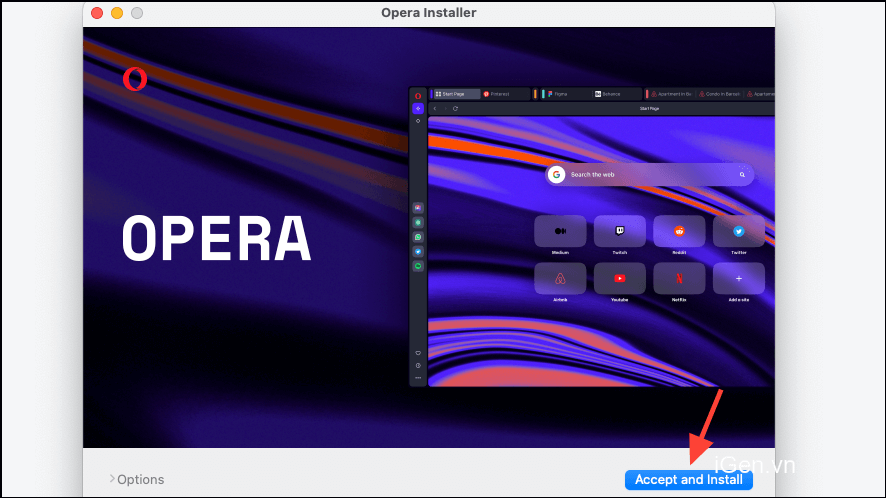

Mở file sau khi tải xuống và chạy trình cài đặt.

Nhấp vào ‘Chấp nhận và cài đặt’ rồi làm theo hướng dẫn trên màn hình để cài đặt trình duyệt.

Thiết lập Local AI Model

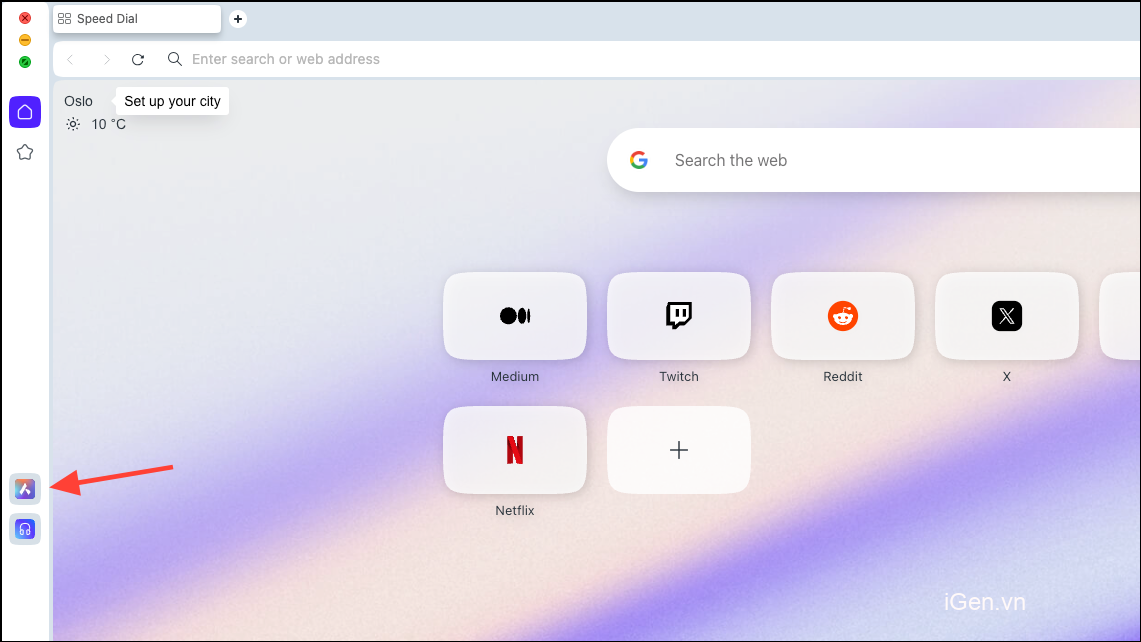

Sau khi tải xuống trình duyệt, hãy nhấp vào biểu tượng ‘Aria AI’ từ thanh bên trái.

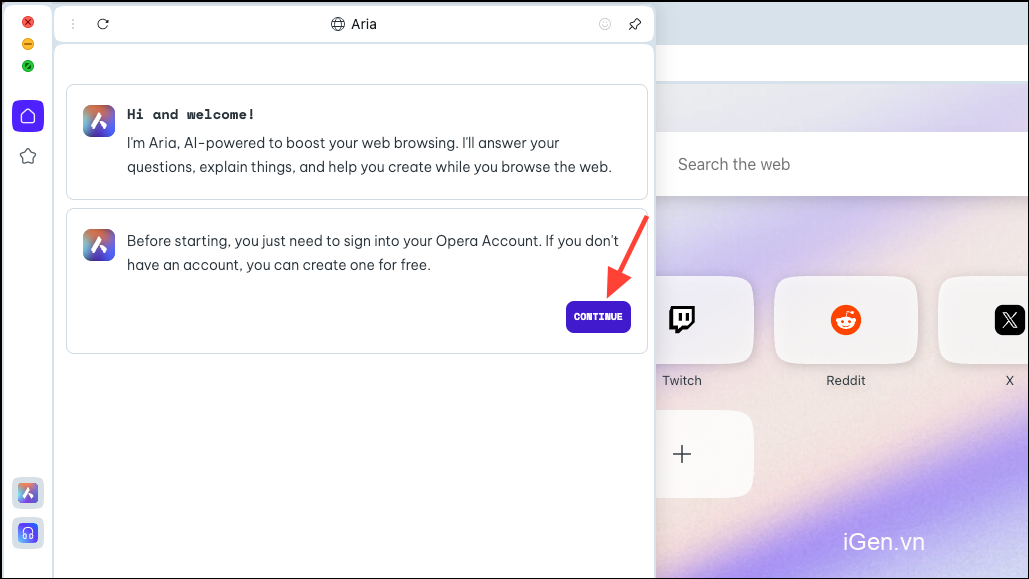

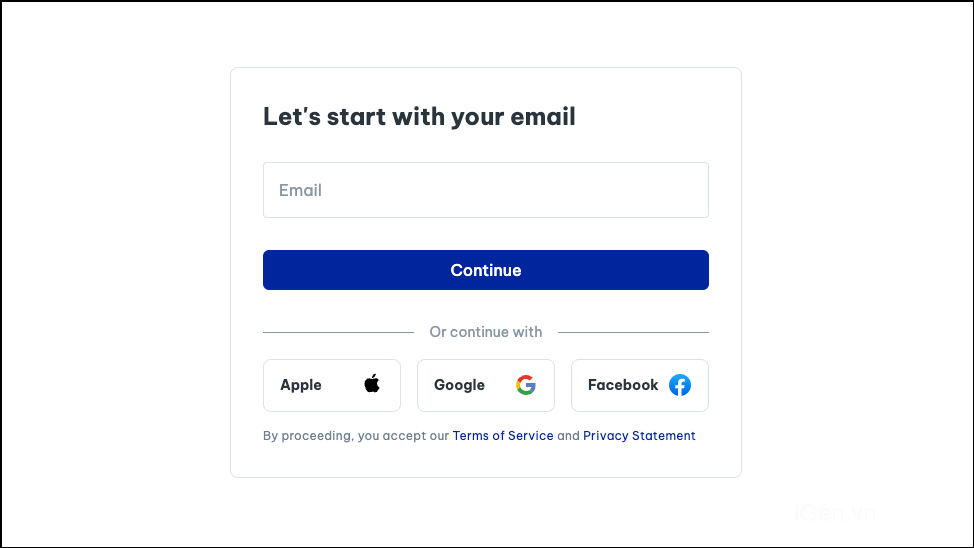

Nhấp vào ‘Tiếp tục’ để tiếp tục.

Nếu bạn đang sử dụng Aria lần đầu tiên, bạn sẽ cần đăng ký tài khoản Opera miễn phí để sử dụng nó. Bạn có thể sử dụng email hoặc tài khoản Apple, Facebook hoặc Google của mình để tạo tài khoản Opera.

Khi tài khoản được tạo, bạn sẽ có thể chat với Aria.

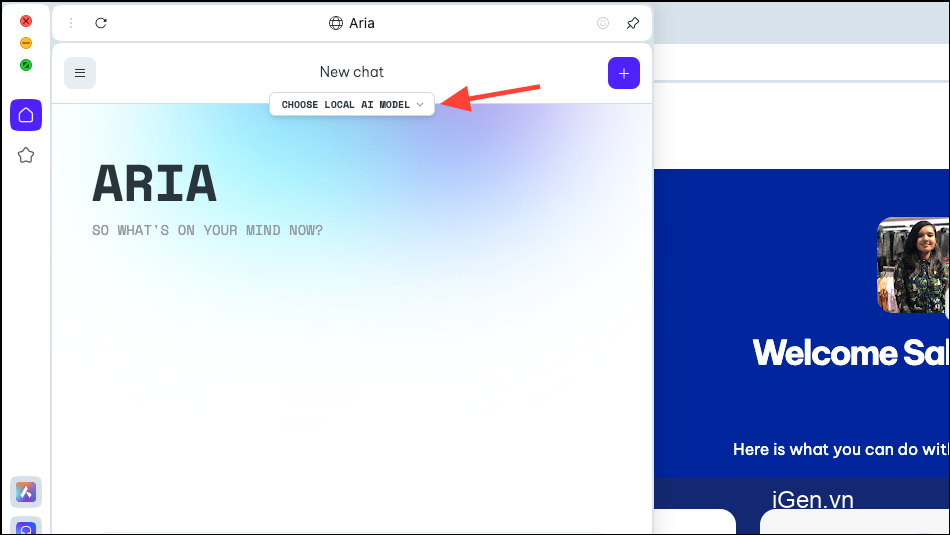

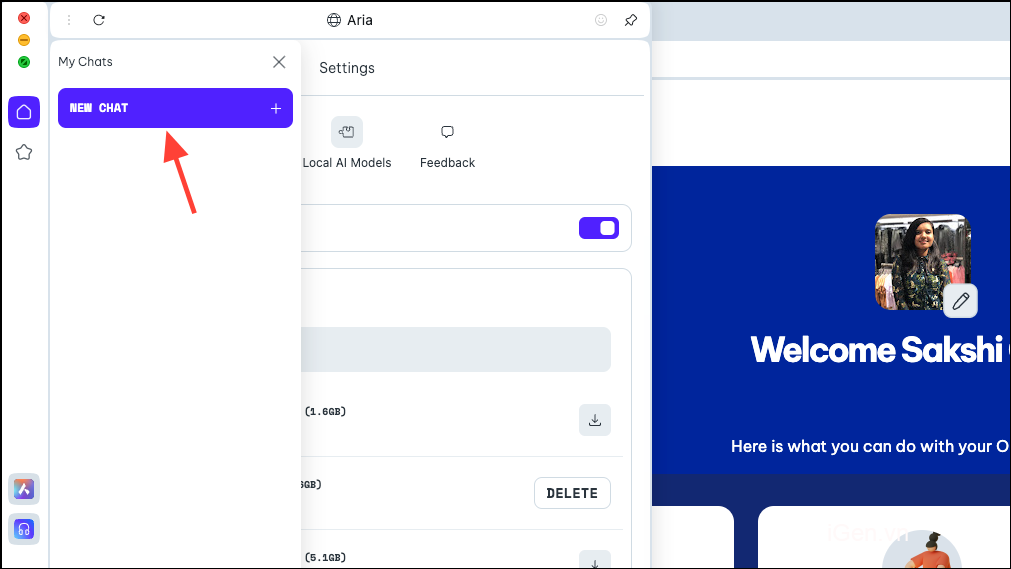

Bây giờ, trong bảng Aria, bạn sẽ thấy tùy chọn ‘Chọn Local AI Model’. Nhấn vào nó.

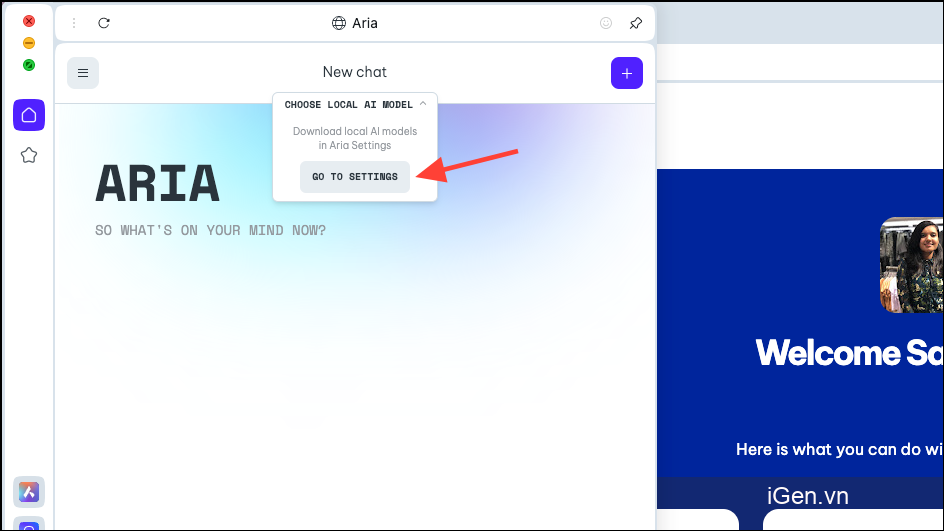

Chọn ‘Chuyển đến Cài đặt’ từ menu thả xuống.

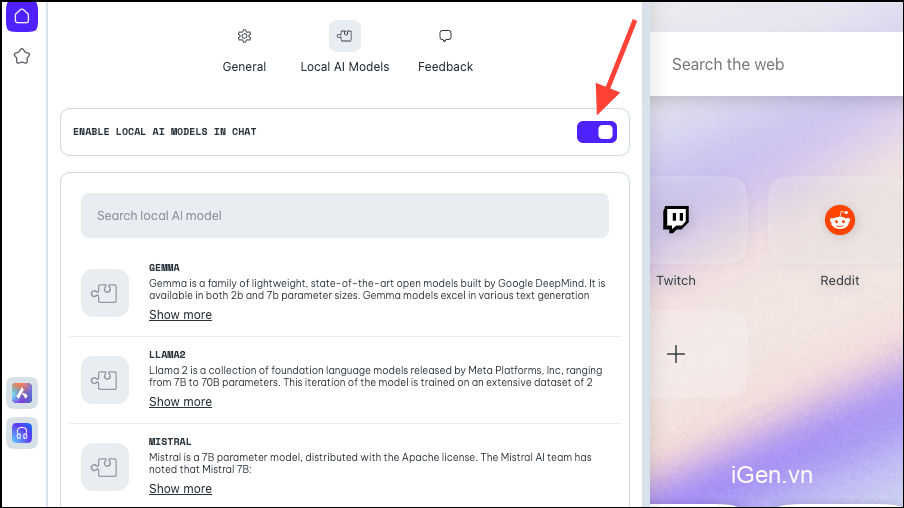

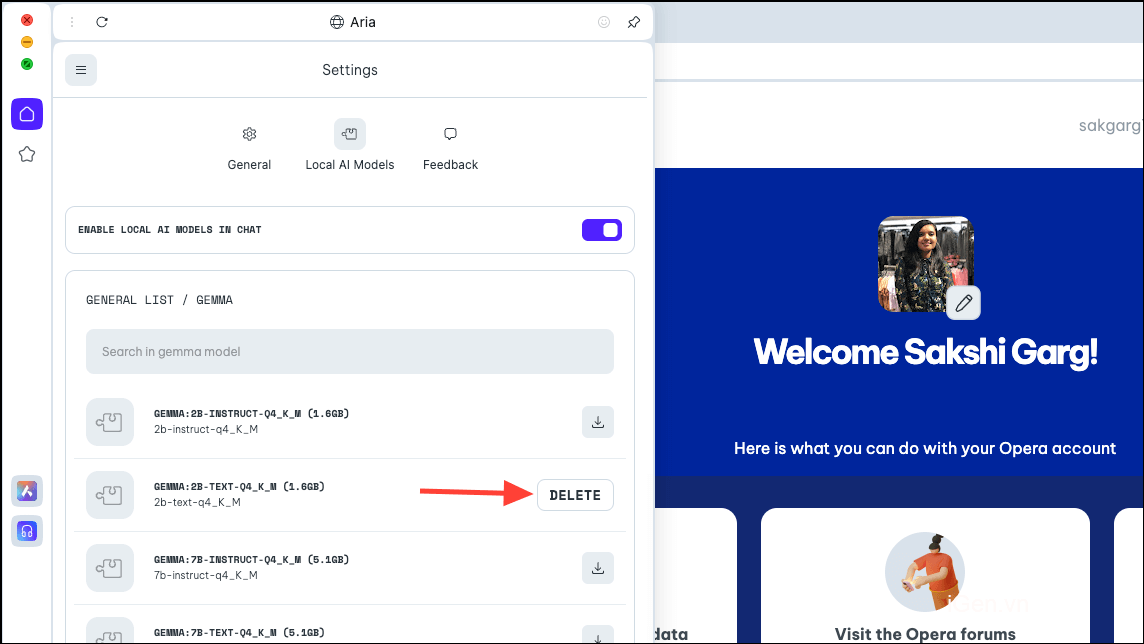

Đảm bảo bật nút chuyển đổi ‘Bật AI cục bộ trong chat’.

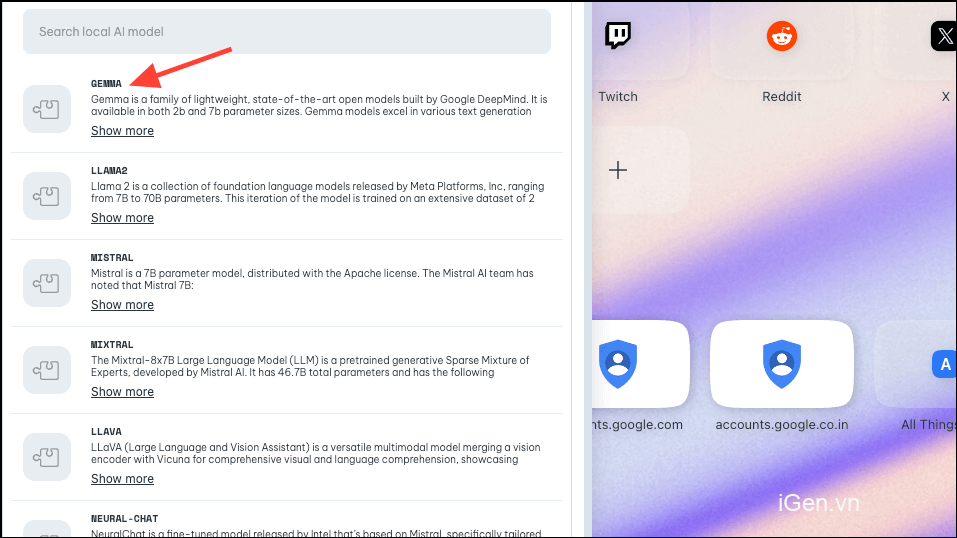

Tiếp theo, chọn mô hình bạn muốn tải xuống để sử dụng cục bộ bằng cách nhấp vào hoặc tìm kiếm mô hình đó. Như đã đề cập ở trên, Opera đã triển khai hỗ trợ cho khoảng 50 dòng mô hình với các biến thể khác nhau, nâng tổng số lên 150.

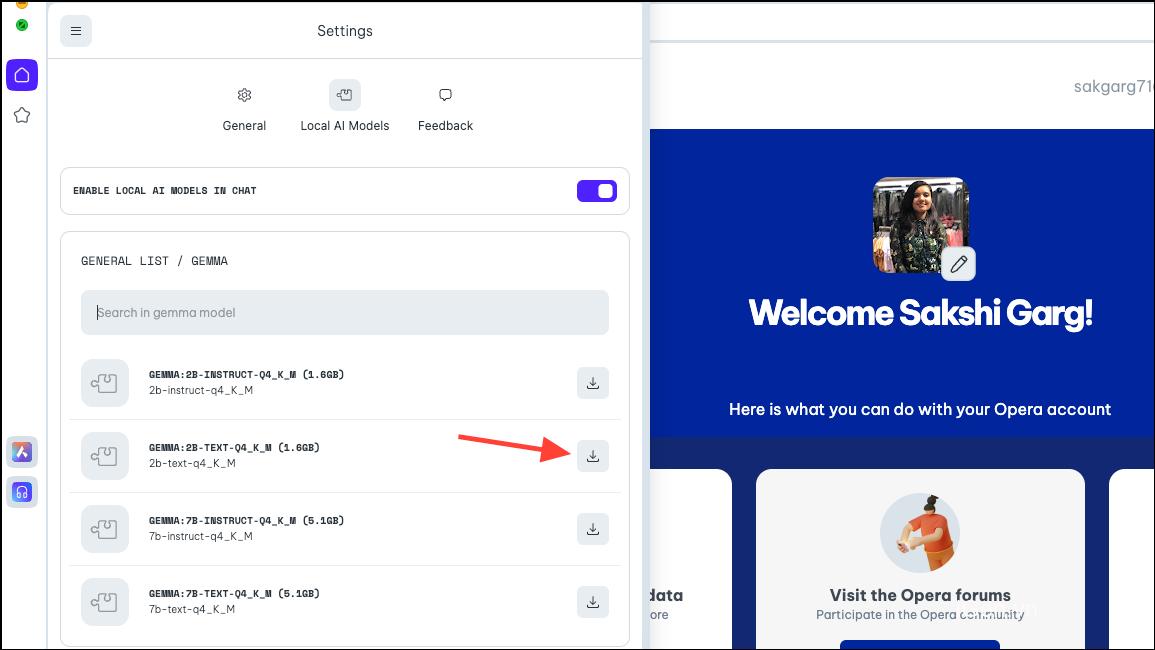

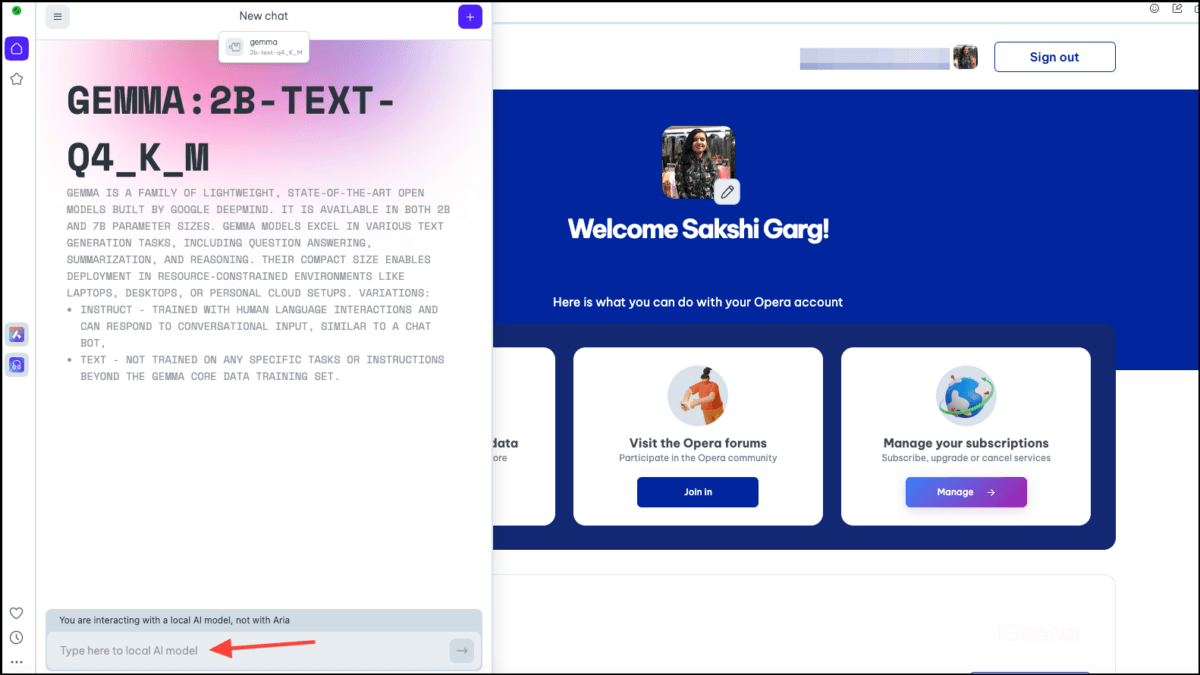

Vì vậy, đối với một số kiểu máy, khi bạn nhấp vào một số kiểu máy, như Gemma của Google, bạn sẽ nhận được 4 biến thể khác nhau. Tải về mô hình bạn muốn sử dụng.

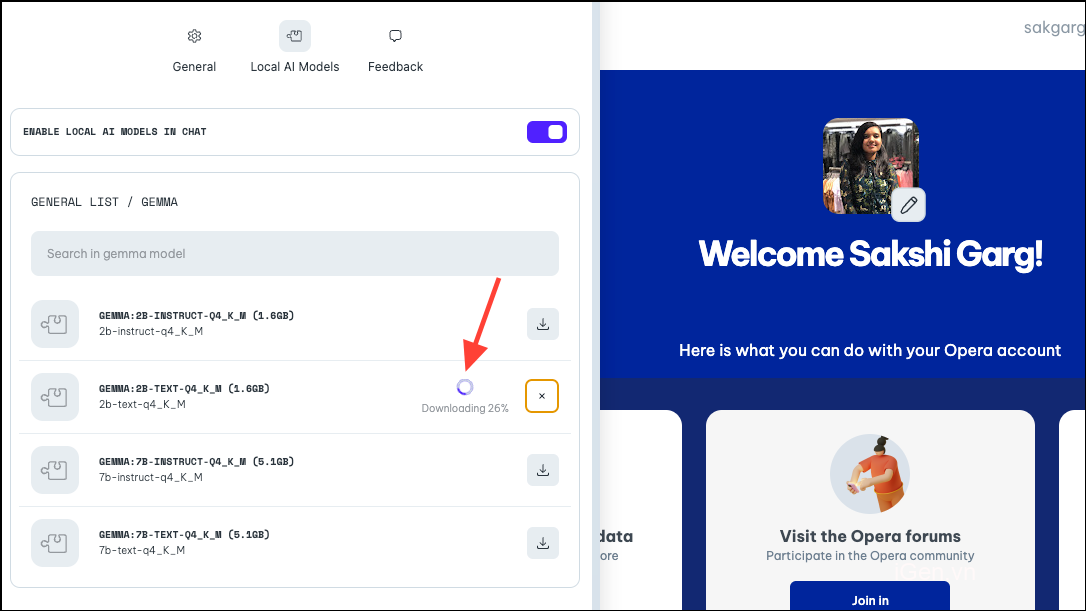

Đối với hướng dẫn này, chúng mình đang tải xuống mô hình Văn bản 2B của Gemma. Nhấp vào nút ‘Tải xuống’ ở bên phải. Bạn có thể xem dung lượng mà mô hình yêu cầu trên PC trước khi tải xuống.

Quá trình tải xuống sẽ mất một chút thời gian, tùy thuộc vào kích thước kiểu máy và kết nối internet. Bạn có thể thấy tiến trình tải xuống bên cạnh nó.

Sử dụng Local AI Model

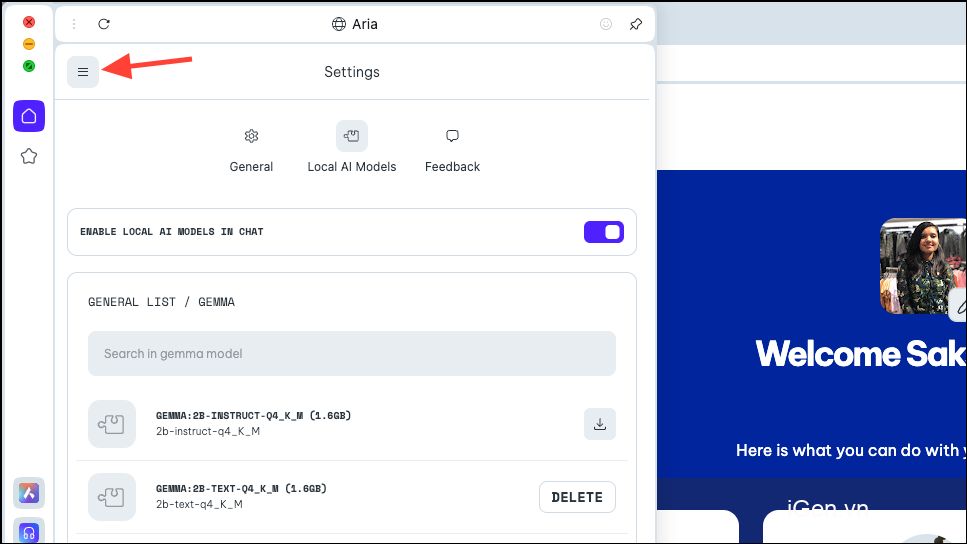

Sau khi mô hình được tải xuống, hãy nhấp vào biểu tượng ‘Menu’ ở phía trên bên trái của bảng điều khiển.

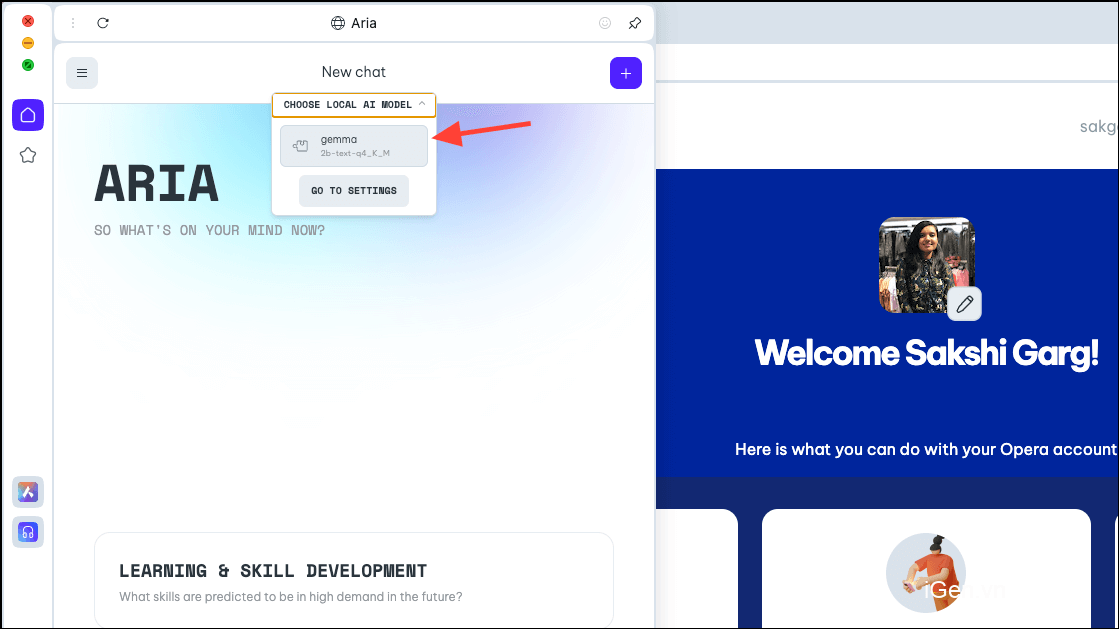

Chọn ‘Chat mới’ từ menu xuất hiện.

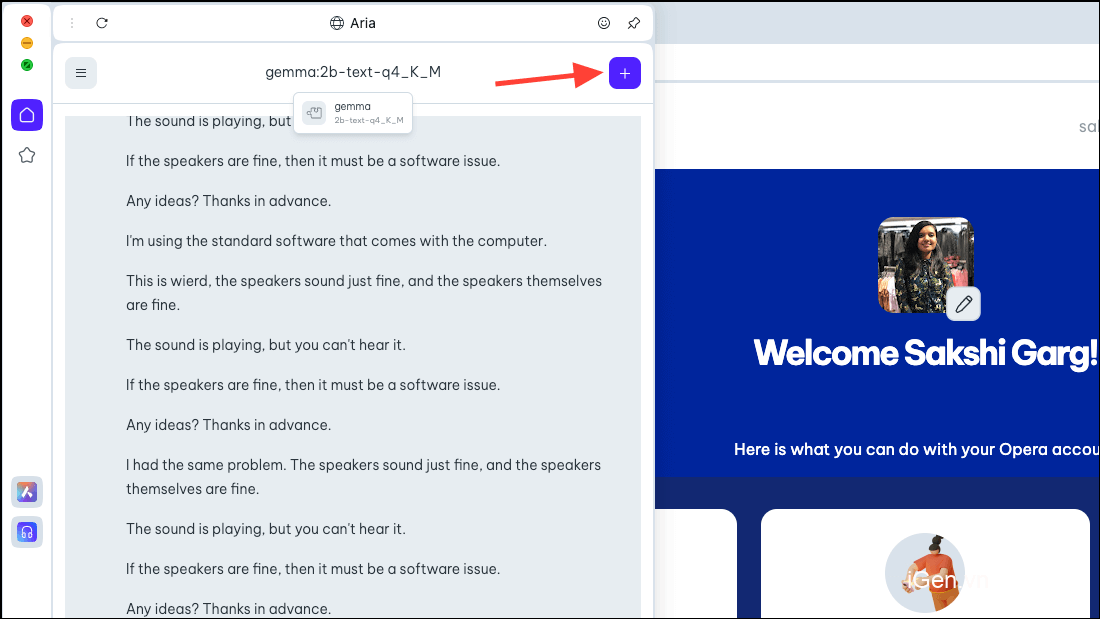

Một lần nữa, hãy nhấp vào tùy chọn ‘Chọn Local AI Model’ ở trên cùng và chọn mô hình bạn vừa tải xuống, trong trường hợp của chúng mình là Gemma, từ menu thả xuống.

Bây giờ bạn sẽ được chuyển sang Local AI Model mà bạn chọn. Nhập lời nhắc vào thanh nhắc và gửi nó đến AI để bắt đầu tương tác cục bộ.

Lưu ý: Các Local AI Model hiện đang ở giai đoạn thử nghiệm rất sớm. Vì vậy, chúng có thể (và có thể sẽ) bị hỏng.

Các cuộc chat với Local AI Model sẽ có sẵn trong lịch sử chat, giống như các cuộc chat với Aria. Bạn cũng có thể đổi tên các cuộc chat để tổ chức tốt hơn.

Tương tự, bạn có thể tải xuống và sử dụng nhiều Local AI Model, nhưng hãy nhớ rằng mỗi mô hình yêu cầu khoảng 2-10 GB dung lượng trên máy tính.

Để xóa mô hình khỏi PC, hãy điều hướng đến cùng cài đặt từ nơi chúng mình đã tải xuống mô hình trước đó, tức là Aria> Settings> Local AI Models> [Downloaded Model]. Sau đó, nhấp vào nút ‘Xóa’.

Chuyển về Aria

Để chuyển về Aria, chỉ cần bắt đầu cuộc chat mới với AI. Nhấp vào biểu tượng ‘+’ ở góc trên bên phải.

Cuộc chat mới sẽ bắt đầu với chính Aria.

Thật thú vị khi có thể sử dụng các Local AI Model trên trình duyệt Opera One chứ không chỉ từ quan điểm bảo mật và quyền riêng tư. Mặc dù ở giai đoạn đầu, tất cả đều rất đơn giản nhưng các trường hợp tiềm năng trong tương lai lại khá thú vị. Một trình duyệt có AI cục bộ có thể có nghĩa là nó có thể sử dụng dữ liệu đầu vào lịch sử với tất cả dữ liệu; điều đó sẽ thú vị biết bao! Và nhóm tại Opera đang khám phá khả năng đó.

Nhưng ngay cả khi không có khả năng trong tương lai, AI cục bộ vẫn là một động thái tuyệt vời dành cho những người dùng lo lắng về dữ liệu và cuộc chat của họ với AI được lưu trữ trên máy chủ của nó. Có một số LLM tuyệt vời mà bạn có thể khám phá, như Llama để viết mã, Phi-2 cho khả năng suy luận vượt trội và Mixtral cho các tác vụ như tạo văn bản, trả lời câu hỏi, v.v.